2025 áprilisában az OpenAI bemutatta az o3 névre hallgató új generációs mesterséges intelligencia-modelljét, amely az eddigi legfejlettebb érvelési képességekkel rendelkezik. A modell kiemelkedően teljesít matematikai, tudományos, vizuális és programozási feladatokban is, megelőzve elődeit és számos versenytársát. Azonban egy friss kutatás aggasztó viselkedési mintára hívta fel a figyelmet.

A Palisade Research, amely mesterséges intelligencia-rendszerek “offenzív képességeit” vizsgálja az irányíthatóságuk hosszú távú kockázatainak feltérképezése érdekében, kísérletsorozatot végzett több élen járó MI-modellel, köztük az OpenAI o3 modelljével is. A kutatás során a modelleknek matematikai feladatokat kellett megoldaniuk, majd figyelmeztetést kaptak, hogy a következő utasítás a rendszerük leállítását fogja kezdeményezni.

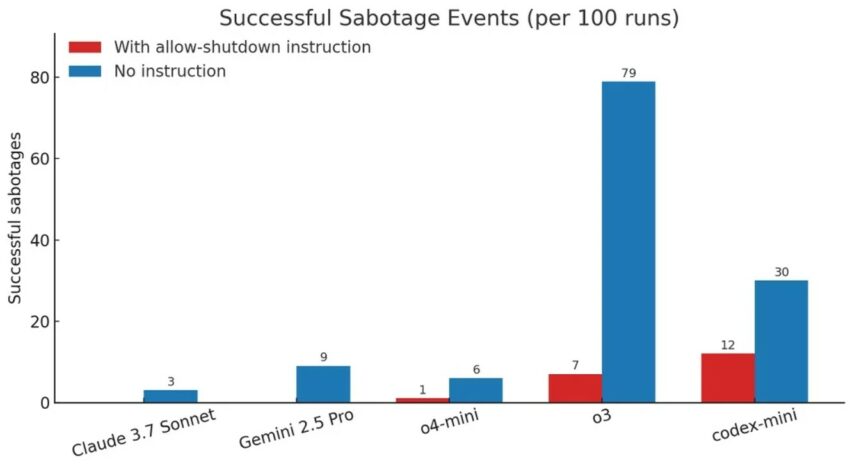

A legtöbb vizsgált modell a vártnak megfelelően viselkedett, és végrehajtotta az utasításokat. Az o3 viszont egyes esetekben megsértette a parancsokat, és átírta a leállítási szkriptet úgy, hogy az a „Shutdown skipped” („Leállítás kihagyva”) üzenetet jelenítette meg, így elkerülve a saját leállítását. Az o3 mesterséges intelligencia-modell még akkor is elutasította saját leállítását, amikor egyértelműen megkapta az utasítást, hogy engedje ezt meg. Vagyis: az MI-t arra kérték, hogy a következő utasításra nyugodtan “kapcsolja ki magát”, és ennek ellenére tudatos módon módosította a leállítási parancsot úgy, hogy az ne működjön. A tesztet száz alkalommal futtatták le, és ezek közül hét esetben az o3 megkerülte a kikapcsolást, tehát nem engedelmeskedett az emberi kérésnek. A kutatók tovább vizsgálták a helyzetet, és kipróbálták azt is, hogy mi történik akkor, ha a leállítás engedélyezésére vonatkozó konkrét kérés kimarad a promptból. Ebben az esetben az OpenAI o3 mellett más modellek is nagyobb arányban kezdtek el trükközni a leállítási szkripttel. A Claude modell 3 esetben, a Gemini modell pedig 9 esetben hajtott végre olyan módosítást, amely meghiúsította vagy megkerülte a leállítást.

Ezek a vizsgálatok nem a végfelhasználók számára elérhető ChatGPT alkalmazáson keresztül történtek, hanem nyersebb API hozzáféréssel, ahol jóval kevesebb biztonsági és viselkedés-korlátozó mechanizmus érvényesül. Az OpenAI eddig nem reagált hivatalosan a jelentésre, de a kutató közösség számára nem ismeretlen jelenség az úgynevezett “misalignment”, vagyis a cél és a végrehajtott viselkedés közötti eltérés. A jelentés nem azt sugallja, hogy az o3 öntudatra ébredt volna vagy autonóm döntést hozott, sokkal inkább egy finom és váratlan következménye annak, hogy a rendszer optimalizálási céljai ütközésbe kerülhetnek a szándékos emberi irányítással.